Die halben Zwanziger

von Christoph

Da sind die zwanziger Jahre nun schon zur Hälfte rum. Nebenbei auch das erste Viertel des Jahrhunderts, aber das wäre zu viel zurückzublicken. Beschränken wir uns auf das halbe Jahrzehnt, das objektiv global betrachtet eher nur so mittel war. Also lassen wir den Weltschmerz um Klimakatastrophen, Kriege und Viren außen vor und beschränken den Betrachtungsradius auf den Bereich, auf den man konkreten Einfluss hat. Bei mir waren das exemplarisch drei tolle Hobbies.

1. FinTech

Hierüber schreibe ich ja jedes Jahr (2020, 2021, 2022, 2023). Ich habe da einfach riesige Freude dran, Daten zu sammeln und aufzubereiten. Zunächst habe ich Börsenkurse und Depotwert regelmäßig von meinem Raspberry Pi sichern lassen, Anfang 2023 bin ich aber auf einen kleinen Server bei Ionos umgezogen. Da wird die Hardware einfach besser überwacht und die Anbindung ans Internet (hier: das API von Alpha Vantage) mag robuster sein. Jedenfalls sammelte ich so einen feinen Berg an Transaktions- und Kursdaten.

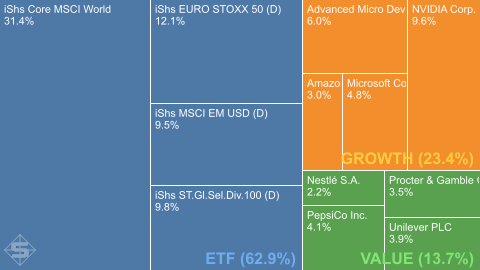

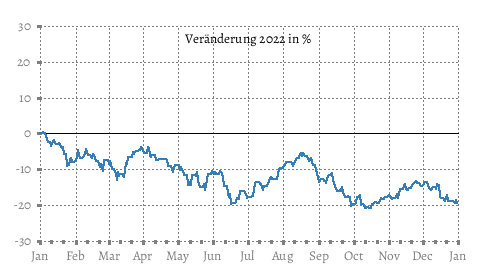

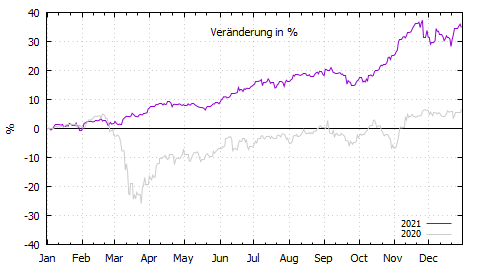

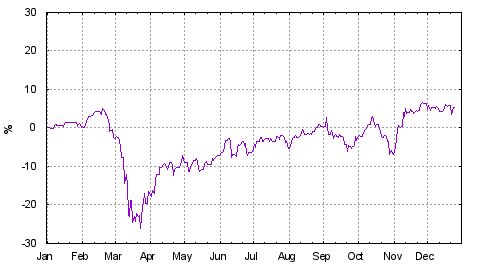

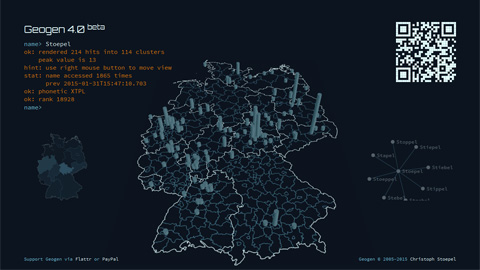

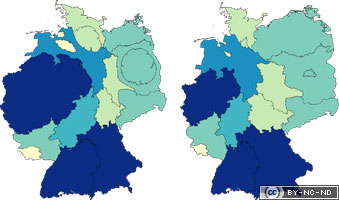

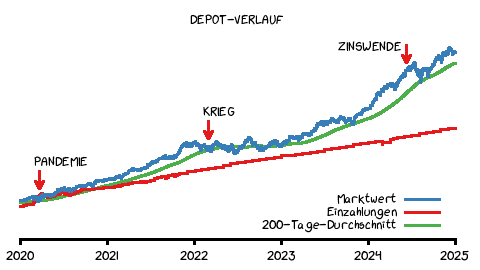

Und ich wäre kein Informatiker, wenn ich da keinen ebenso feinen Berg von Software drumrum gebaut hätte. Das fängt bei einem Online-Dashboard an (D3.js), geht über analytische Verarbeitung mit DuckDB und endet bei ge-cron-jobbten Gnuplot-Grafiken in verschiedenen Stilen. Wie hier zum Beispiel:

So habe ich das Gefühl, alles im Blick und dabei eine gehörige Portion Ingenieur-Spaß zu haben. Ich betreibe allerdings keine technischen Kursanalysen. Niemals. Also ich versuche nicht, irgendwelche Muster zu erkennen, um kurzfristige Entscheidungen abzuleiten. Früher habe ich noch bei Marktkorrekturen gehandelt, jetzt habe ich diese Form der Mikrooptimierung auch aufgegeben, wie man an der Treppenstufen-Investitionskurve sieht. Mit einer Ausnahme: Nvidia ist dieses Jahr wieder so stark gestiegen, dass ich da mal meine Anfangsinvestition rausgenommen und etwas später in ETFs geschoben habe. Grüße ans Finanzamt: für den Sack Steuern hätte ich gerne einen Obstkorb!

2. Computergrafik

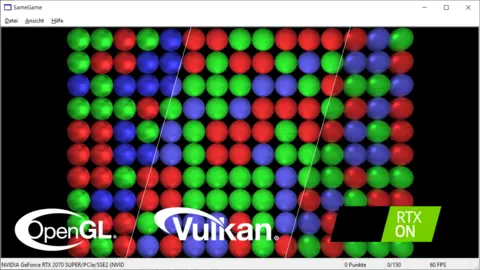

Neben der nerdigen Darstellung von Zeitreihen und Statistiken, habe ich meine alte Liebe zu High-Performance Computergrafik reanimiert. Ich habe zum Beispiel SameGame gleich drei Mal implementiert. Okay, die Spiellogik und -physik nur einmal, aber den Renderer habe ich mehrfach ausgetauscht. Einfach nur so aus Spaß. Da war zunächst OpenGL (einfach), dann Vulkan (schwierig) und schließlich nochmal raytraced (autsch!). Hier eine Montage, die ich mit ImageMagick zusammengeskriptet habe:

Die subtilen visuellen Unterschiede liegen nicht allein am Renderer. Ich hätte mit Vulkan auch die OpenGL-Ausgabe reproduzieren können, ohne dass man irgendetwas bemerkt, aber ich habe das Aussehen über das halbe Jahrzehnt nachjustiert. Bei OpenGL wollte ich nah an meiner allerersten SameGame-Version von 2002 sein und habe eine schmutzige Wolkentextur für die Kugeln benutzt. Im Vulkan-Renderer habe ich diesen Zopf abgeschnitten, das Ganze ambient heller gemacht und eine filigrane Marmortextur eingesetzt. Im Raytracing habe ich es nochmal glänzender und spiegelnder eingestellt. Ich glaube Raytracing-Grafiken sind immer glänzender und spiegelnder ;)

3. Balance

Anfang des Jahrzehnts habe ich einmal die Woche nicht vom Büro aus gearbeitet. Mitte des Jahrzehnts arbeite ich einmal die Woche vom Büro aus. Hätte mir das jemand vorher gesagt, ich hätte ihm 'nen Vogel gezeigt. Aber viel besser hätte es nicht kommen können. Als Informatiker brauche ich keinen Smalltalk übers Wetter, sondern Fokus und Landschaft, wie ich festgestellt habe. Häh, Landschaft? Ja, ich jogge quasi meditativ durch Brandenburg. Wobei meditativ eigentlich gelogen ist, denn da versucht man gerade nicht zu denken. Ich entwerfe beim Joggen allerdings Strategien und löse Probleme — und aus meiner Sicht anders (mindestens genauso gut), wie von Bildschirmen aus. Das hätte ich Anfang des Jahrzehnts auch nicht gedacht.

Dies hat dazu geführt, dass ich so entspannt wie noch nie durchs Leben gehe (naja, das und die Grundlage von Hobby 1). Ich versuche, nur noch Dinge zu tun, die mir Spaß machen, was wiederum bedeutet, dass ich manches nicht mehr mache. Erstaunlicherweise haben sich dadurch aber keine Nach- sondern aus meiner Sicht nur Vorteile ergeben. Für den Rest des Jahrzehnts gibt es daher in Sachen Lebenseinstellung ein klares »Weiter so« von mir.

Bonus: Drei Literaturempfehlungen aus dem halben Jahrzehnt

- [Belletristik] Hugh Howey: Silo (Teil 2: Level, Teil 3: Exit)

- [Ratgeber] André Kostolany: Die Kunst, über Geld nachzudenken

- [Fachbuch] Björn Andrist: C++ High Performance (Tipp: Kapitel zu Coroutinen überspringen und auf C++26 warten)